Il metodo per spegnere un’intelligenza artificiale andata fuori controllo

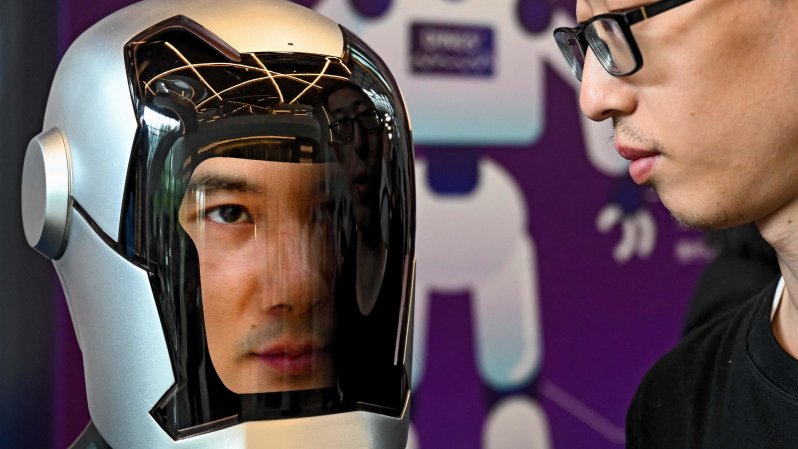

Lo chiamano ‘kill switch’. Tradotto, spegnimento. Un’estrema ratio. Una mossa estrema per fare in modo che un’intelligenza artificiale andata fuori controllo possa causare danni all’umanità. Se ne discute da tempo. Da quando l’avvento dei nuovi strumenti di Ai ha reso noto al mondo il loro potenziale. Ma soprattuto da quando i principali sviluppatori di Ai dicono di non sapere esattamente cosa c’è dentro un’Ai. Cosa avviene con precisione nelle ‘black box’, le scatole nere dove la magia delle intelligenze artificiali prende forma.

La proposta di legge e i malumori in Silicon Valley

Secondo il Financial Times lo ‘spegnimento’ è un’opzione che la California starebbe studiando per una proposta di legge. In California hanno sede alcune delle società più importanti che sviluppano Ai. Meta, OpenAi, Anthropic, Salesforce, solo per citare le più note.

L’allarme

L’allarme dei dipendenti Google e OpenAI: “Con l’IA si rischia l’estinzione ma le aziende hanno troppi interessi”

05 Giugno 2024

Il disegno di legge prevede che le società che sviluppano Ai assicurino alle agenzie statali che non stanno lavorando a modelli con capacità potenzialmente dannose per l’umanità, come la possibilità di progettare o creare armi di distruzione di massa o attacchi informatici su vasta scala. Ma è lo ‘spegnimento’ il punto più controverso della legge. Quello che a quanto riportano i media di settore americani starebbe creando più malumori tra i colossi della Silicon Valley e le startup che si occupano di Ai.

I timori per l’avvento di una Ai malevola

Tutto ruota intorno al fatto che le preoccupazioni per la rapida crescita e il vasto potenziale della tecnologia AI sono aumentate. Elon Musk, uno dei primi investitori di OpenAI, ha già definito questa tecnologia una “minaccia esistenziale” per l’umanità. Di recente, un gruppo di dipendenti attuali ed ex di OpenAI ha pubblicato una lettera aperta in cui si sottolinea che le principali aziende di IA non hanno una sufficiente supervisione governativa e pongono “seri rischi” per l’umanità.

L’Ai è qualcosa che inquieta. Inquieta per la sua stessa natura, la sua capacità di emulare il pensiero umano, le decisioni umane, fare quello che finora l’uomo si era illuso potesse essere la sua proprietà fondamentale: pensare. Ora, il dibattito sulla capacità reale delle Ai di pensare o meno è aperto. Ma il punto è che – coscienza o non coscienza – questi strumenti hanno capacità di calcolo infinitamente superiore alle umane capacità. E, volendo, una bomba o un attacco informatico potrebbero anche essere in grado di organizzarlo.

Il tentativo di regolare una tecnologia con ombre e luci

I legislatori cercano di muoversi in un terreno nuovo e paludoso. Lo ha fatto l’Europa con l’Ai act. Lo stanno facendo diversi stati nel mondo, compresa la California. Lo spegnimento è l’arma finale. Il kill switch serve come misura di sicurezza per prevenire che un’IA fuori controllo possa causare danni. Questo è particolarmente importante nei sistemi di IA altamente autonomi che operano in ambienti sensibili o critici. Inoltre prevedere dei sistemi di controllo superiori garantirebbe che gli esseri umani mantengano il controllo finale sui sistemi di IA. In questo modo, anche se un’IA sviluppa comportamenti indesiderati, gli operatori umani possono intervenire e fermare il sistema.

Approfondimento

EscapeGPT, BlackhatGPT e le altre: così i criminali stanno usando l’intelligenza artificiale

07 Giugno 2024

Al momento non si sa che forma potrebbe avere questo ’kill switch”. Alcuni parlando di un pulsante fisico, o un comando software, o di un protocollo di emergenza che disattiva tutte le operazioni dell’IA. In alcuni casi, il kill switch può anche includere procedure automatiche che monitorano il comportamento dell’IA e attivano la disattivazione se vengono rilevati certi criteri di rischio. Ipotesi. Che però insieme confermano la necessità sentita dai legislatori di mettere dei paletti a questa tecnologia.

Autore del post: La Repubblica Tecnologia Fonte: https://www.repubblica.it/rss/tecnologia/rss2.0.xml Continua la lettura su: https://www.repubblica.it/tecnologia/2024/06/11/news/kill_switch_spegnimento_intelligenza_artificiale-423191493/?rssIl Ministero delle Pari Opportunità finanzia il tuo corso digitale

Chiedi tutte le informazioni a [email protected] |