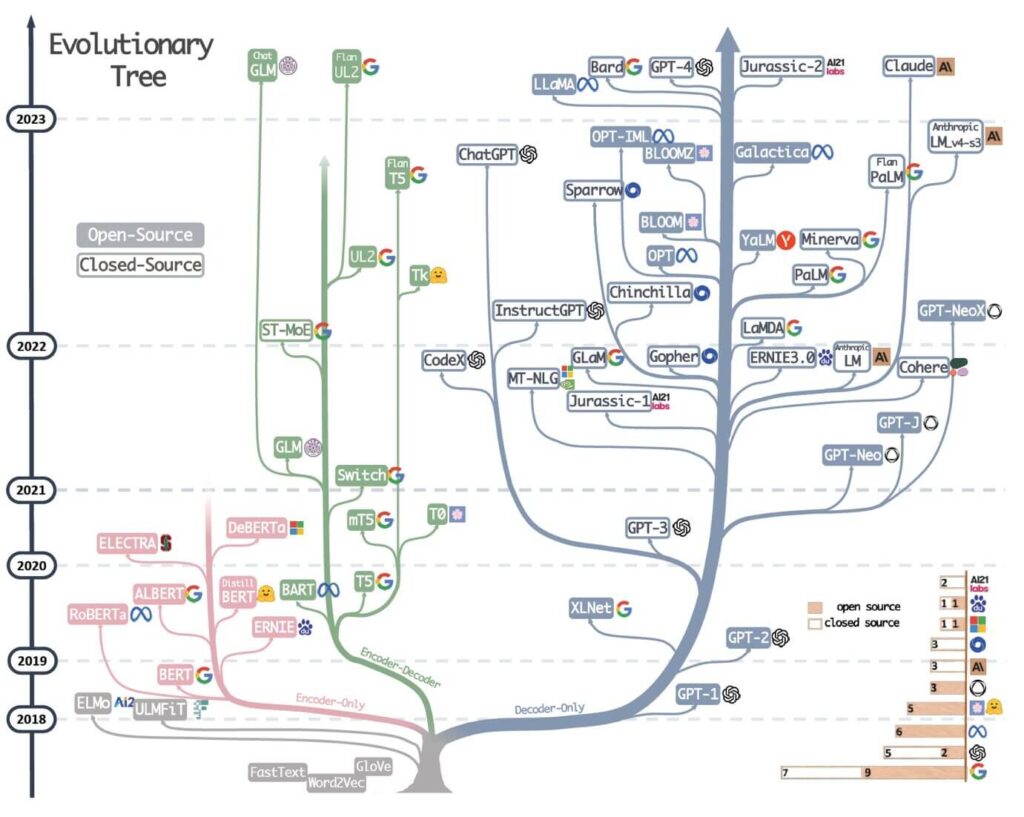

Sistemi di intelligenza artificiale, la mappa completa

I sistemi consolidati si trovano a fronteggiare sfide da parte di innovatori emergenti che stanno introducendo approcci rivoluzionari, ridefinendo le possibilità nel campo del machine learning e del reasoning artificiale.

I giganti consolidati: evoluzione e adattamento

GPT-4 di OpenAI mantiene la sua posizione di riferimento nel settore, grazie a una combinazione di scala e sofisticazione tecnica. La vera forza del sistema risiede nella sua architettura transformer ottimizzata, che ha stabilito nuovi standard per la comprensione contestuale e la generazione di contenuti.

L’introduzione di GPT-4V (Vision) ha esteso queste capacità al dominio visivo, mentre GPT-4 Turbo ha portato miglioramenti significativi nelle performance e nel context window.

L’approccio Anthropic

Claude-3, nelle sue tre varianti – Opus, Sonnet e Haiku – rappresenta un approccio distintivo all’AI. Anthropic ha implementato il Constitutional AI, un framework che integra considerazioni etiche direttamente nell’architettura del modello.

Opus, in particolare, ha introdotto innovazioni significative nel reasoning multipassaggio, permettendo analisi più profonde e articolate.

La risposta di Google

Gemini rappresenta il tentativo di Google di ridefinire lo stato dell’arte dell’AI. La sua architettura nativa multimodale differisce significativamente dagli approcci retrofit dei concorrenti.

Il sistema è stato progettato fin dall’inizio per comprendere e generare contenuti attraverso diversi media, con un’integrazione particolarmente sofisticata tra comprensione linguistica e visiva.

I nuovi challenger: innovazioni tecniche rivoluzionarie

Il sistema di IA cinese DeepSeek ha rivoluzionato l’approccio al reinforcement learning con il suo ormai noto modello R1.

DeepSeek: ripensare il reinforcement learning

L’innovazione principale risiede in un nuovo framework di training che ottimizza l’apprendimento in modi precedentemente inesplorati. Il sistema utilizza un meccanismo di reward shaping che incorpora feedback multilivello, permettendo un apprendimento più naturale e contestualmente appropriato.

L’architettura di R1 introduce diverse innovazioni tecniche chiave:

- Un nuovo sistema di attention scaling che migliora l’efficienza computazionale

- Un meccanismo di context compression che permette di gestire sequenze più lunghe

- Un approccio innovativo alla tokenizzazione che migliora la comprensione semantica

Mistral: l’evoluzione del MoE

Mixtral 8x7B di Mistral ha ridefinito l’architettura Mixture of Experts (MoE). Il sistema implementa un routing dinamico degli esperti che riduce significativamente l’overhead computazionale tipico dei sistemi MoE. Questa innovazione permette prestazioni paragonabili a modelli molto più grandi, ma con requisiti di calcolo notevolmente inferiori.

Le caratteristiche tecniche distintive includono:

- Un nuovo algoritmo di routing che ottimizza la selezione degli esperti

- Un sistema di caching intelligente che riduce la latenza

- Un’architettura di parallelizzazione che migliora l’efficienza dell’inferenza

Yi-34B: l’efficienza ripensata

Yi-34B ha introdotto innovazioni significative nella compressione dei modelli. Utilizzando tecniche avanzate di pruning e quantizzazione, il team ha sviluppato metodi per ridurre la dimensione del modello mantenendo prestazioni competitive. Questo approccio potrebbe influenzare significativamente il futuro sviluppo di modelli più efficienti.

L’impatto sul mercato e le applicazioni

L’emergere di questi nuovi player sta democratizzando l’accesso all’AI avanzata. L’approccio open source di molti nuovi entranti sta creando un ecosistema più diversificato e accessibile. Hugging Face, con la sua iniziativa OpenR1, sta facilitando la diffusione di queste innovazioni nella comunità degli sviluppatori.

Specializzazione e verticalizzazione

I nuovi modelli stanno anche guidando una tendenza verso la specializzazione. rStar-Math di Microsoft Asia, per esempio, ha dimostrato come l’ottimizzazione per domini specifici possa portare a prestazioni superiori in aree specializzate.

L’evoluzione delle architetture

L’approccio al training sta evolvendo significativamente. I nuovi modelli stanno esplorando:

- Training distribuito più efficiente

- Nuovi metodi di ottimizzazione

- Approcci ibridi che combinano diverse tecniche di apprendimento

Efficienza e scalabilità

La ricerca dell’efficienza sta guidando innovazioni significative:

- Nuove tecniche di compressione dei modelli

- Ottimizzazione dell’inferenza

- Architetture più efficienti in termini di risorse

Il futuro dell’AI: tendenze e prospettive

Il mercato sta vedendo una interessante dinamica di convergenza e differenziazione. Mentre alcuni aspetti delle architetture AI stanno convergendo verso best practice comuni, stiamo anche assistendo a una crescente differenziazione nelle applicazioni e nelle implementazioni specifiche.

L’importanza dell’open source

Il movimento open source sta giocando un ruolo sempre più centrale. Initiative come:

- Il progetto OpenR1 di Hugging Face

- Le implementazioni aperte di Mixtral

- I contributi della comunità a Yi-34B stanno accelerando l’innovazione e democratizzando l’accesso alle tecnologie AI avanzate.

Sfide e opportunità

I nuovi sviluppi portano con sé sfide significative:

- Bilanciamento tra efficienza e prestazioni.

- Gestione della complessità crescente.

- Scalabilità delle nuove architetture.

Opportunità di mercato

Le innovazioni stanno aprendo nuove opportunità:

- Applicazioni in settori precedentemente non accessibili

- Nuovi modelli di business

- Possibilità di personalizzazione avanzata

Prospettive future

Il panorama dell’AI sta attraversando una fase di profonda trasformazione. L’emergere di nuovi player con approcci innovativi sta sfidando i paradigmi esistenti e aprendo nuove possibilità. La combinazione di innovazione tecnica, democratizzazione attraverso l’open source e specializzazione sta creando un ecosistema più ricco e diversificato.

Le implicazioni di questa evoluzione sono profonde. Mentre i giganti tecnologici continuano a spingere i limiti con risorse massive, i newcomer stanno dimostrando che l’innovazione può venire da qualsiasi direzione. Il futuro dell’AI sembra orientato verso una maggiore diversità di approcci e soluzioni, con benefici potenziali per l’intero settore.

La vera sfida per il futuro sarà bilanciare questa rapida innovazione con considerazioni di sostenibilità, etica e accessibilità. Il successo a lungo termine dipenderà non solo dalle capacità tecniche, ma anche dalla capacità di integrare queste innovazioni in modo responsabile e benefico per la società.

Autore del post: Riccardo Petricca Fonte: https://www.agendadigitale.eu/feed/ Continua la lettura su: https://www.agendadigitale.eu/mercati-digitali/giganti-e-challenger-la-mappa-completa-dei-sistemi-di-intelligenza-artificiale/Il Ministero delle Pari Opportunità finanzia il tuo corso digitale

Chiedi tutte le informazioni a [email protected] |